Сиолошная

Канал SeeAll'а с новостями (и мыслями о них) из мира NLP, VR и космоса.

Более подробно смотри в первом сообщении в канале (оно закреплено). А еще у нас есть чат! Заходи: https://t.me/+i_XzLucdtRJlYWUy Связанные каналы | Похожие каналы

44 608

подписчиков

Популярное в канале

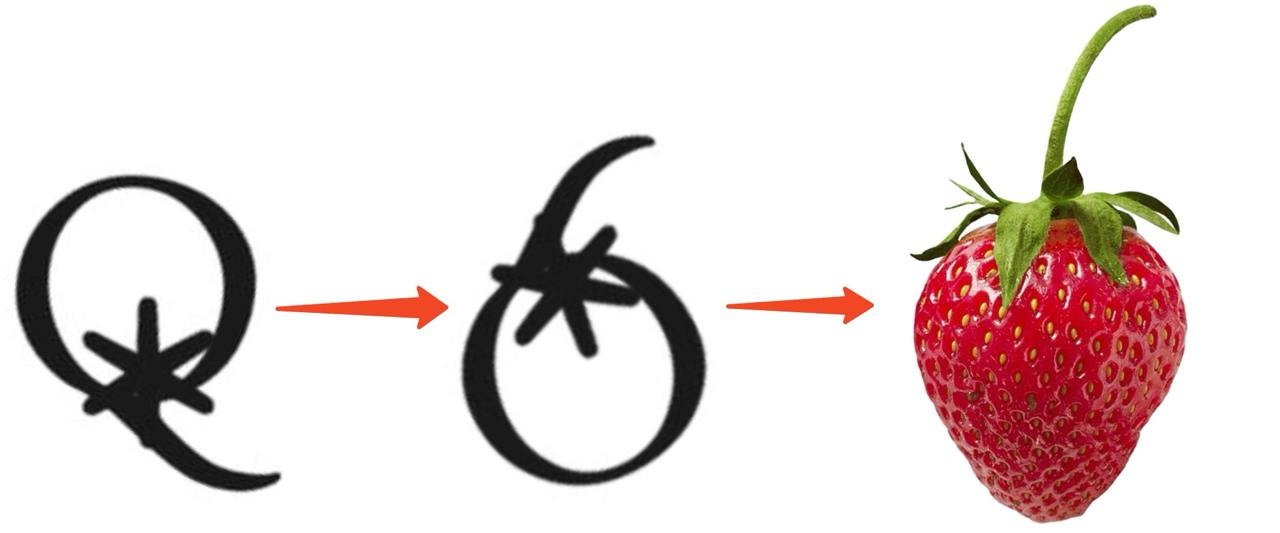

😏 Клубничку не хотите? 😏Ну, Strawberry? Тут Reuters пишут, что это — кодовое название проекта Ope...

Вышел анализ доходов и расходов OpenAI от авторитетного издания The Information. Он основывается ...

А вот видео робота в действии — за полторы минуты он берёт 4 детали с одной стойки и перекладывае...

По традиции, SpaceX выпустили ролик с итогами прошедшего тестового запуска Starship. Посмотреть е...

Увидел сравнение Starship и Saturn V (в масштабе), решил написать пост для того, чтобы давать ссы...